(Tippapatt/Shutterstock)

A IA pode estar dirigindo o ônibus quando se trata de investimentos. Mas, à medida que as empresas lutam com seus lançamentos de IA, estão percebendo que os problemas com os dados são o que os está impedindo. Isso é o que lidera os bancos de dados para fazer investimentos nos principais recursos de engenharia de dados e operações, que se manifestaram nesta semana com o lançamento de seus produtos de designer de Lakeflow e Lakebase nesta semana em sua cúpula de dados + ai.

Lagoflow, que Databricks lançado um ano atrás Em sua conferência 2024, é essencialmente uma ferramenta ETL que permite que os clientes ingem dados de diferentes sistemas, incluindo bancos de dados, fontes de nuvem e aplicativos corporativos e, em seguida, automatizam a implantação, operação e monitoramento dos dutos de dados.

Embora o Lakeflow seja ótimo para engenheiros de dados e outras pessoas técnicas que sabem codificar, não é necessariamente algo que as pessoas de negócios se sentem confortáveis usando. Os banco de dados ouviram de seus clientes que queriam ferramentas mais avançadas que lhes permitissem criar pipelines de dados de uma maneira mais automatizada, disse Joel Minnick, vice -presidente de marketing da Databricks.

“Os clientes estão nos perguntando um pouco ‘Por que existe essa escolha entre simplicidade e foco nos negócios ou produção? Por que eles precisam ser coisas diferentes?'”, Ele disse. “E dissemos que, enquanto analisamos isso, eles não precisam ser coisas diferentes. E é isso que é o que o designer de Lakeflow é, sendo capaz de expandir a experiência de engenharia de dados nos analistas de negócios não técnicos e dar a eles uma maneira visual de construir dutos”.

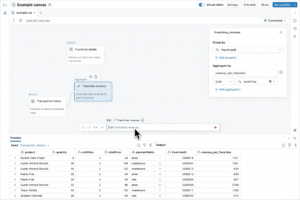

O novo Lakeflow Designer do Lakeflow, do Databricks, possui interfaces GUI e PNL para desenvolvimento

O Lakeflow Designer é uma ferramenta sem código que permite aos usuários criar pipelines de dados de duas maneiras diferentes. Primeiro, eles podem usar a interface gráfica para arrastar e soltar fontes e destinos para os pipelines de dados usando um gráfico acíclico direcionado (DAG). Como alternativa, eles podem usar a linguagem natural para informar ao produto o tipo de pipeline de dados que deseja construir. Em ambos os casos, o Lakeflow Designer está utilizando o Databricks Assistant, o copiloto movido a LLM da empresa, para gerar o SQL para criar os pipelines de dados reais.

Os pipelines de dados construídos pelo Lakeflow Designer são tratados de forma idêntica aos pipelines de dados construídos da maneira tradicional. Ambos se beneficiam do mesmo nível de segurança, governança e rastreamento de linhagem que o código gerado pelo ser humano teria. Isso se deve à integração com o catálogo da Unity no Lakeflow Designer, disse Minnick.

“Nos bastidores, falamos sobre isso ser dois mundos diferentes”, disse ele. “O que está acontecendo enquanto você está passando por esse processo, arrastando -se e se soltando ou apenas pedindo ao Assistente pelo que você precisa, é tudo é sustentado pelo próprio Lakeflow. Então, como tudo o que o ANSI SQL está sendo gerado para você como você está passando por esse processo, todas essas conexões no catálogo da unidade que se destacam que isso tem linhagem, que tenha a audiência, isso tem que isso tem uma linhagem.

Os pipelines criados com o Lakeflow Designer são extensíveis; portanto, a qualquer momento, um engenheiro de dados pode abrir e trabalhar com os pipelines em uma interface de código-primeiro. Por outro lado, qualquer pipeline originalmente desenvolvido por um engenheiro de dados que trabalha em SQL de nível inferior pode ser modificado usando as interfaces visual e PNL.

“A qualquer momento, em tempo real, enquanto você faz alterações de ambos os lados, essas alterações no código são refletidas no designer e as alterações no designer se refletem no código”, disse Minnick. “E assim, essa divisão que está entre essas duas equipes é capaz de desaparecer completamente agora.”

A Lakeflow Designer entrará em breve. Enquanto isso, o próprio Lakeflow agora está geralmente disponível. A empresa também anunciou novos conectores para o Google Analytics, ServiceNow, SQL Server, SharePoint, PostgreSQL e SFTP.

Além de aprimorar a integração de dados e o ETL – o Bane of CIOs – Databricks está procurando levar a bola para a frente em outra disciplina tradicional de TI: processamento de transações on -line (OLTP).

O Databricks tem se concentrado principalmente em análises avançadas e IA desde que foi fundada em 2013 pelo criador da Apache Spark Matei Zaharia e outros da Universidade da Califórnia Amplab. Mas com o lançamento da Lakebase, agora está entrando no negócio OLTP de Postgres.

Lakebase é baseada no banco de dados PostGres de código aberto, sem servidor, desenvolvido pela Neon, que Databricks adquirido no mês passado. Como a empresa explicou, a ascensão da IA agêntica exigiu um banco de dados operacional confiável para abrigar e servir dados.

“Todo aplicativo de dados, agente, recomendação e fluxo de trabalho automatizado precisa de dados rápidos e confiáveis na velocidade e escala dos agentes de IA”, disse a empresa. “Isso também exige que os sistemas operacionais e analíticos convergem para reduzir a latência entre os sistemas de IA e fornecer às empresas informações atuais para tomar decisões em tempo real”.

O Databricks disse que, no futuro, 90% dos bancos de dados serão criados pelos agentes. Os bancos de dados surgiram sob demanda por agentes de IA da Databricks serão Lakebase, que a empresa, segundo a empresa, poderá ser lançada em menos de um segundo.

Trata-se de preencher os mundos de IA, análise e operações, disse Ali Ghodsi, co-fundador e CEO da Databricks.

“Passamos os últimos anos ajudando as empresas a criar aplicativos e agentes de IA que podem raciocinar seus dados proprietários com a plataforma de inteligência de dados do Databricks”, afirmou Ghodsi. “Agora, com a Lakebase, estamos criando uma nova categoria no mercado de bancos de dados: um banco de dados moderno do Postgres, profundamente integrado à casa de Lakehouse e hoje de desenvolvimento”.

Lakebase está em pré -visualização pública agora. Você pode ler mais sobre isso em Um blog de banco de dados.

Itens relacionados:

O Databricks quer tirar a dor da construção, implantando agentes de IA com tijolos

Databricks Nabs Neon para resolver o gargalo do banco de dados AI

Os Databricks revelam o LakeFlow: uma ferramenta unificada e inteligente para engenharia de dados

Leave a Reply